NVIDIA、AI およびデジタル生物学を前進させる、大規模言語モデル クラウド サービスを発表

NVIDIA NeMo LLM サービスにより、開発者は巨大な言語モデルのカスタマイズが可能になり、NVIDIA BioNeMo サービスが分子、タンパク質、DNA の生成や予測の研究を支援

2022 年 9 月 20 日、カリフォルニア州サンタクララ — GTC — NVIDIA は

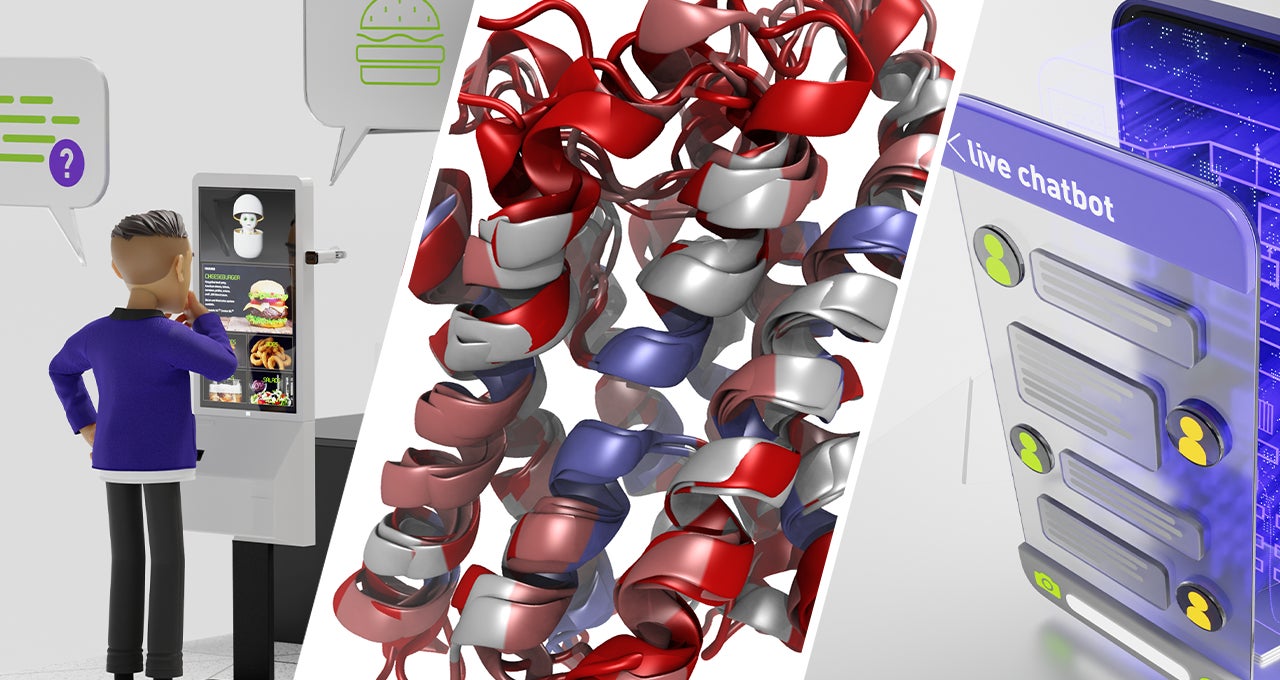

本日、NVIDIA NeMo Large Language Model サービス( https://www.nvidia.com/en-us/gpu-cloud/nemo-llm-service/ )と NVIDIA BioNeMo LLM サービス( https://www.nvidia.com/en-us/gpu-cloud/bionemo/ )という、2 つの大規模言語モデル (LLM) クラウド AI サービスを発表しました。これらのサービスにより、開発者は簡単に LLM を採用し、コンテンツ生成、テキスト要約、チャットボット、コード開発、ならびにタンパク質構造や生体分子特性の予測などのためにカスタマイズされた AI アプリケーションを導入できるようになります。

NeMo LLM サービスにより、開発者は NVIDIA によって管理されたインフラストラクチャ上でプロンプト学習( https://docs.nvidia.com/deeplearning/nemo/user-guide/docs/en/main/nlp/nemo_megatron/prompt_learning.html )と呼ばれるトレーニング手法を使い、事前トレーニングされたいくつもの基盤モデルを迅速にカスタマイズすることができます。NVIDIA BioNeMo サービスは、LLM のユースケースを言語だけでなく、科学アプリケーションにまで広げ、製薬企業やバイオテクノロジ企業の創薬を加速させる、クラウド アプリケーション プログラミング インターフェイス (API) です。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、次のように述べています。「大規模言語モデルには、すべての産業を変容させる潜在力があります。基盤モデルをチューニングできる機能により、数百万人の開発者が巨大なモデルを一から構築する必要なく、LLM のパワーを利用して言語サービスを創出し、科学的発見を促進できるようになります」

NeMo LLM サービスがプロンプト学習によって精度を高め、展開を加速

NeMo LLM を使うことで、開発者は独自のトレーニング データを使って多様なサイズの基盤モデル (30 億パラメーターのモデルから、Megatron 530B のような世界最大規模のモデル) をカスタマイズできるようになります。一からモデルをトレーニングする方法では数週間から数か月を必要としていましたが、この作業は数分から数時間で完了します。

モデルは、P-チューニングと呼ばれる手法を使うプロンプト学習によってカスタマイズされます。これにより、研究者はわずか数百の例を使うだけで、元々は数十億のデータ ポイントでトレーニングされた基盤モデルを迅速にカスタマイズできるようになります。このカスタマイズ作業により、タスク特有のプロンプト トークンが生成されます。その後、これらトークンが基盤モデルと組み合わされ、特定のユースケースに対してより高い精度とより適切なレスポンスを提供します。

開発者は、同じモデルを複数のユースケースに対応できるようにカスタマイズし、多様なプロンプト トークンを生成できるようになります。プレイグラウンド機能により、コーディングをせずに簡単にモデルの実験やインタラクションが可能になり、業界固有のユースケースで LLM の効果およびアクセシビリティをさらに高めることができます。

展開の準備が整うと、チューニングされたモデルをクラウド インスタンスまたはオンプレミスのシステム、もしくは API から実行することができます。

BioNeMo LLM サービスにより、研究者は巨大モデルのパワーを活用可能に

BioNeMo LLM サービス( https://blogs.nvidia.com/blog/2022/09/20/bionemo-large-language-models-drug-discovery/ )には、化学および生物学用の 2 つの新しい BioNeMo 言語モデルが含まれています。タンパク質、DNA および化学的データに対応しており、研究者は生物学的配列のパターンを発見し、洞察を得られるようになります。

BioNeMo により、研究者は数十億個のパラメーターが含まれているモデルを活用して、自身の研究の幅を広げることができます。これらの大規模モデルは、タンパク質の構造や遺伝子間の進化的関係についてのより多くの情報を格納することができ、さらに治療に応用可能な、斬新な生体分子の生成もできるようになります。

クラウド API を通じて Megatron 530GB などトレーニング済みモデルへのアクセスが可能に

基盤モデルのチューニングに加えて、LLM サービスでは、クラウド API を通じてトレーニング済みのカスタム モデルを使用することもできます。

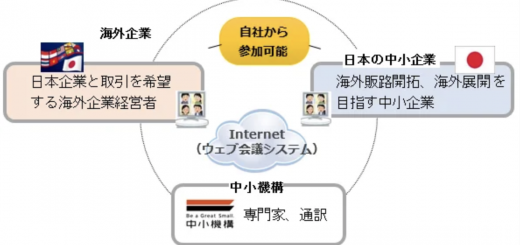

このオプションにより、開発者は Megatron 530B を含む多様なトレーニング済み LLM を利用することができます。LLM サービスを使う開発者は、現在オープン ベータが利用可能な、NVIDIA NeMo Megatron フレームワーク( https://developer.nvidia.com/blog/?search_posts_filter=NeMo+Megatron )を使って構築された T5 および GPT-3 モデルを利用して、多様なアプリケーションや多言語サービスの要件に対応することができます。

自動車、コンピューティング、教育、ヘルスケア、テレコミュニケーションおよびその他の業界における主要な企業は、NeMo Megatron を使って、中国語、英語、韓国語、スウェーデン語やその他の言語でのお客様向けの画期的なサービスを他社に先駆けて展開しています。

提供予定

NeMo LLM と BioNeMo の両サービス、ならびに クラウド API は、来月よりアーリーアクセスを通じて利用可能となる予定です。現在、開発者は詳細を知るために申請することができます。

NeMo Megatron フレームワークのベータ リリースは現在 NVIDIA NGC™ ( https://www.nvidia.com/ja-jp/gpu-cloud/ )より入手可能で、NVIDIA DGX™ Foundry ( https://www.nvidia.com/ja-jp/data-center/dgx-foundry/ )および NVIDIA DGX SuperPOD™( https://www.nvidia.com/ja-jp/data-center/dgx-superpod/ )、ならびに Amazon Web Services、Microsoft Azure および Oracle Cloud Infrastructure ( https://blogs.oracle.com/cloud-infrastructure/post/oracle-partners-with-nvidia-to-solve-the-largest-ai-and-nlp-models )のアクセラレーテッド クラウド インスタンスで実行できるように最適化されています。

NeMo Megatron フレームワークを活用してみたい開発者は、NVIDIA LaunchPad ( https://www.nvidia.com/ja-jp/data-center/launchpad/ )ラボにて無料でお試しいただけます。

NVIDIA AI を活用した大規模言語モデルについての詳細を知るためには、GTCにおけるジェンスン フアンの基調講演( https://www.nvidia.com/gtc/keynote/ )のリプレイをご視聴ください。

NVIDIA について

1993 年の創業以来、NVIDIA (NASDAQ: NVDA) は、アクセラレーテッド コンピューティングのパイオニアとして活動してきました。1999年の GPU の発明は、PC ゲーミング市場の成長に拍車をかけ、コンピュータ グラフィックスを再定義し、現在の AI 時代の火付け役となりました。NVIDIA は現在、データセンター規模の製品を提供するフルスタック コンピューティング企業であり、産業のあり方を大きく変えています。詳細は、こちらのリンクから:https://nvidianews.nvidia.com/